Home Europakarte Weltkarte Arbeiten Impressum Sitemap

3.3.1. TraceEine einfache und anspruchslose Methode eine Erklärung zu erstellen, besteht darin, den Trace auszugeben. Ein Trace ist eine Aufzeichnung der einzelnen Schritte, die das System während der Lösungssuche vornimmt.117 Diese Aufzeichnungen können unterschiedlich sein. EMYCIN besitzt sogar drei Arten eines Trace:118

Die erste Form ist die am häufigsten anzutreffende Form eines Trace. Die zweite Form hat ihr gegenüber den Vorteil, daß sie mehr Informationen bietet und auch WHY-NOT-Fragen beantworten kann.119 Vor allem bei großen Systemen wird dieser Trace aber durch die große Anzahl an gescheiterten Regeln sehr lang und unübersichtlich.

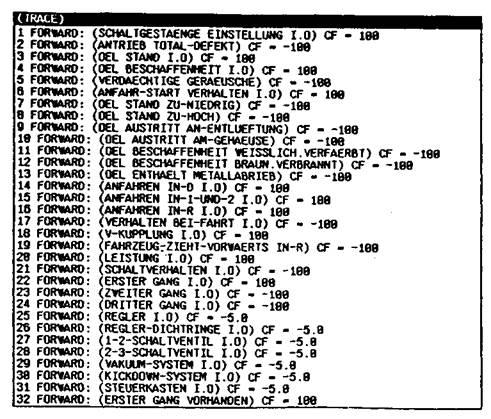

Abb. 3: Beispiel für einen Trace120 Diese Tracetechnik ist die verbreitetste Form der Erklärungsfähigkeit in wissensbasierten Systemen.121 Sie ist nicht nur eine Form der Erklärung, sondern auch die Basis für die meisten anderen Erklärungskonzepte.122 Es stellt sich nun die Frage, wie eine simple Aufzeichnung der Schlußfolgerungen zur Beantwortung von Fragen verwendet werden kann. Mit Hilfe der Tracetechnik lassen sich die Fragen WHY?, HOW? und WHY NOT? beantworten, indem ein Teil oder der gesamte Trace ausgegeben wird. Eine HOW-Frage kann beantwortet werden, indem der komplette Trace der Problemlösung angezeigt wird. Daraus läßt sich ersehen, wie die Schlußfolgerung gezogen wurde. Eine WHY-Frage läßt sich beantworten, indem die augenblicklich betrachtete Regel angezeigt wird123 und die Prämissen, die bereits erfüllt sind124. Um die Regel anwenden oder ablehnen zu können, benötigt das System die angeforderten Informationen. Die WHY-NOT-Frage läßt sich nur mit einem Trace beantworten, der nicht nur die erfolgreichen Regeln, sondern auch die gescheiterten Regeln aufzeichnet.125 Das System listet als Erklärung alle Regeln auf, die das erfragte Ergebnis liefern würden und zeigt die unerfüllten Prämissen an.126 Bei einem Vergleich der Erklärungsfähigkeit eines Trace mit den Anforderungen, die in Kapitel 3.2. aufgestellt wurden, fällt auf, daß nur die Anforderungen des Knowledge Engineer erfüllt werden. Ein Trace ist eine sehr gute Hilfe für Systementwickler, aber für die Anwender, insbesondere für die unwissenden Anwender, ist diese Erklärungsfähigkeit selten ausreichend.127 Die Hauptgründe dafür liegen darin, daß der Programmverlauf für den Benutzer häufig verwirrend ist, da zu viele Details dargestellt werden.128 Zu diesen langen und deshalb unübersichtlichen Trace kommt es dadurch, daß während der Lösungssuche meißt eine große Anzahl an Regeln angewendet werden.129 Darüber hinaus kann die Art der Schlußfolgerung von der des menschlichen Experten abweichen.130 Des weiteren listet ein Trace nur die verwendeten Regeln auf und vermittelt auf diese Weise nur wenig Wissen über die Strategie und warum eine Lösung korrekt ist.131 116 Vgl. PUPPE, F.: Einführung in Expertensysteme, a.a.O.,

S. 128. 117 Vgl. SWARTOUT, W.R.: Producing Explanations and Justifications of Expert Consulting Programs, MIT Laboratory for Computer Science, Technical Report: MIT/LCS/TR-251, Ph.D., Camebridge, Massachusetts 1981, S. 17. 118 Vgl. JACKSON, P.: Explaining Expert Systems Behaviour, in: ALVEY IKBS EXPERT SYSTEMS THEME (HRSG.): Workshop on•Explanation', Report and Proceedings, University of Surrey, 20.-21. March 1986, Herts 1986, S. 85 (83-95). 119 Vgl. STERLING, L.; YALCINALP, Ü.L.: Explaining Prolog Based Expert Systems Using a Layered Meta-Interpreter, in: SRIDHARAN, N.S. (ED.): Proceedings of the Eleventh International Joint Conference on Artificial Intelligence (IJCAI-89), August 20.-25., 1989, Detroit, Michigan, Vol. 1, San Mateo, California 1989, S. 66 (66-71). 120 121 Vgl. BERRY, D.C.; BROADBENT, D.E.: Expert Systems and the Man-Machine Interface. a.a.O., S. 21. 122 Vgl. KIDD, A.L.: The Consultative Role of an Expert System,

in: JOHNSON, P.; COOK, S. (EDS.): People and Computers:

Designing the Interface, Proceeding of the Conference of

the British Computer Society Human Computer Interaction

Specialist Group, University of East Anglia, 17.-20. Sept.

1985, The British Computer Society Workshop Series,

Camebridge/London/New York/New Rochelle/Melbourne/ Sydney

1985, S. 249 (248-254). 123 Vgl. BRUFFAERTS, A.; HENIN, E.; PIROTTE, A.: A Sound Basis for the Generation of Explanations in Expert Systems, a.a.O., S. 289. 124 Vgl. JABLONSKI, K.: Generierung konjugierter Verben mit TWAICE. Zur Erklärungs- und Instruktionsfähigkeit, Verbundvorhaben WISBER, Nixdorf Computer AG, Memo Nr. 9, September 1986, S. 15. 125 Vgl. STERLING, L.; YALCINALP, Ü.L.: Explaining Prolog Based Expert Systems Using a Layered Meta-Interpreter, a.a.O., S. 66. 126 vgl. JABLONSKI, K.: Generierung konjugierter Verben mit TWAICE. Zur Erklärungs- und Instruktionsfähigkeit, a.a.O., S. 15. 127 Vgl. SOUTHWICK, R.W.: Topic Explanation in Expert Systems,

in: KELLY, B.; RECTOR, A. (EDS.): Proceedings of the 8th

technical conference of the British Computer Society

Specialist Group on Expert Systems, Brighton (UK), 12.-15.

Dec. 1988, Cambridge/New York 1989, S. 47 (47-57). 129 Vgl. ELLIS, C: Explanation in Intelligent Systems, a.a.O., S. 111. 130 Vgl. SWARTOUT, W.R.: A Digitalis Therapy Advisor with Explanations, in: Proceedings of the 5th International Joint Conference on Artificial Intelligence (IJCAI-77), Aug. 22.-25., 1977, Cambridge, Massachusetts, Vol. 2, 1977 Los Altos, California, S. 823 (819-825). 131 Vgl. SOUTHWICK, R.W.: Topic Explanation in Expert Systems, a.a.O., S. 48. |